是一个涉及技术工具、方法和策略的系统化过程,旨在从网页中提取结构化或非结构化的数据,并将其转化为可用的信息,无论是为了市场调研、学术研究还是商业智能,掌握网页解析的技巧都至关重要,以下将从准备工作、核心方法、工具选择、数据清洗到应用场景,全面解析如何高效地获取网页内容。

在开始解析网页之前,准备工作是确保过程顺利的基础,首先需要明确解析目标:是需要提取文本、图片、链接,还是特定的数据字段?电商网站的评论、新闻文章的标题和正文、社交媒体的用户信息等,目标不同,后续方法的选择也会差异,分析网页结构是关键步骤,通过浏览器的开发者工具(通常按F12打开),可以查看网页的HTML代码、CSS样式和JavaScript交互逻辑,重点关注数据的容器标签,如<div>、<table>、<span>等,以及它们的class或id属性,这些通常是定位数据的“路标”,还需要考虑网页的反爬机制,如IP限制、验证码、动态加载等,提前制定应对策略,如使用代理IP、设置请求头或模拟浏览器行为。

网页解析的核心方法主要分为两类:基于规则的方法和基于智能化的方法,基于规则的方法依赖开发者手动编写提取逻辑,例如通过正则表达式匹配特定模式的文本,或使用XPath定位HTML元素,这种方法的优势是精确度高、速度快,适合结构化稳定、变化较少的网页,提取所有<a>标签的href属性,可以通过正则表达式<a\s+href=["'](.*?)["']快速实现,但缺点也很明显:当网页结构发生微小变化时,解析规则可能失效,需要人工维护,相比之下,基于智能化的方法则更灵活,如利用机器学习模型识别网页中的数据块,或通过自然语言处理(NLP)技术提取关键信息,这种方法对网页结构变化的适应性强,但需要较高的技术门槛和训练数据支持。

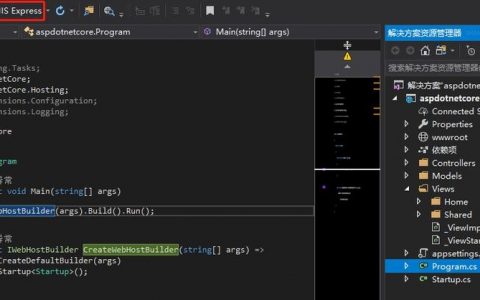

工具的选择直接影响解析效率和效果,对于初学者或中小规模数据提取,浏览器开发者工具自带的“元素选择器”是最直观的工具,可以通过点击元素直接生成XPath或CSS选择器,编程语言方面,Python是网页解析的首选,拥有丰富的库生态。Requests库用于发送HTTP请求获取网页源码,BeautifulSoup库则擅长解析HTML和XML文档,通过标签、属性等定位数据,代码简洁易读;对于需要处理JavaScript渲染的动态网页,Selenium或Playwright可以模拟浏览器操作,等待页面加载完成后再提取数据;而Scrapy框架则适合构建大规模、高效率的爬虫项目,支持异步请求、数据存储和反爬策略,对于非技术用户,可视化工具如Octoparse、ParseHub等提供了拖拽式界面,无需编写代码即可完成数据提取。

获取原始数据后,数据清洗和结构化是不可忽视的环节,网页中常包含大量无关信息,如广告、导航栏、页脚等,需要通过过滤掉非目标元素来保留有效数据,使用BeautifulSoup的find()或find_all()方法结合class或id属性剔除干扰内容,数据格式也需要统一,如去除文本中的多余空格、换行符,将日期格式标准化,或处理缺失值,对于表格数据,可以将其转换为CSV或Excel格式;对于非结构化文本,可利用分词、关键词提取等技术进一步加工,清洗后的数据通常存储为结构化格式,如JSON、数据库表等,便于后续分析和应用。

网页解析的应用场景广泛且多样,在商业领域,企业可通过解析竞品网站的价格、销量和用户评价,制定市场策略;金融机构通过抓取财经新闻和社交媒体情绪,辅助投资决策;学术研究者则利用网络爬虫收集文献数据或公开统计数据,在解析过程中必须遵守法律法规和道德准则,如尊重网站的robots.txt协议(该文件定义了爬虫的访问权限),避免过度请求导致服务器负载,以及不侵犯用户隐私和数据版权,动态网页的解析(如通过AJAX加载的内容)需要特别处理,通常需分析网络请求,直接调用API接口获取数据,这比渲染整个页面更高效。

相关问答FAQs:

Q1: 如何应对网页的反爬机制?

A1: 应对反爬机制需综合多种策略:①设置合理的请求头(如User-Agent、Referer)模拟浏览器访问;②使用代理IP池轮换IP地址,避免单一IP被封;③控制请求频率,添加随机延时(如1-3秒)减少服务器压力;④对于需要登录的网页,使用Selenium模拟登录流程获取cookies;⑤针对验证码,可接入第三方打码平台或使用OCR技术识别;⑥分析网页是否通过API返回数据,优先直接调用接口而非解析HTML。

Q2: 动态网页和静态网页的解析有何区别?

A2: 静态网页的内容在服务器端已生成,HTML源码中包含所有数据,可直接通过Requests获取并使用BeautifulSoup解析;动态网页的内容由JavaScript在客户端动态生成,初始HTML源码可能不包含目标数据,需使用Selenium或Playwright等工具模拟浏览器环境,等待JS执行完成后捕获渲染后的DOM结构,再进行解析,动态网页的数据常通过AJAX请求从API接口获取,可直接分析网络请求找到接口地址,用Requests调用以提高效率。

原文来源:https://www.dangtu.net.cn/article/9014.html

文章来源网络,作者:运维,如若转载,请注明出处:https://shuyeidc.com/wp/323977.html<