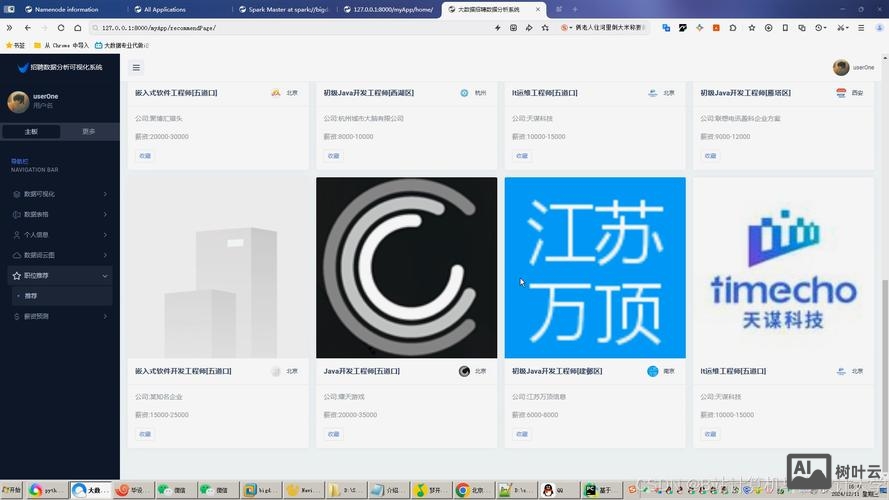

在当前大数据技术蓬勃发展的背景下,Hadoop与Spark作为核心计算框架,已成为企业数据架构中不可或缺的组成部分,相关岗位招聘需求持续旺盛,从技术栈要求、岗位类型到能力模型,Hadoop与Spark招聘呈现出鲜明的行业特征,值得求职者深入理解。

Hadoop招聘通常围绕分布式存储与批处理展开,核心岗位包括Hadoop开发工程师、数据平台架构师等,技术要求上,候选人需熟练掌握HDFS的原理与优化策略,如NameNode高可用、DataNode负载均衡;MapReduce编程模型,包括Combiner、Partitioner等定制化开发;以及YARN资源调度机制,如Capacity Scheduler与Fair Scheduler的配置调优,HBase、Hive、HDFS等组件的协同经验也常被列为加分项,例如通过Hive UDF实现复杂数据清洗,或利用HBase二级索引优化查询性能,企业招聘时,尤其关注候选人解决实际问题的能力,如TB级数据ETL任务优化、小文件问题处理等,这通常通过项目经验或笔试题进行考察。

Spark招聘则更侧重实时计算与内存处理,热门岗位涵盖Spark开发工程师、大数据算法工程师等,技术栈方面,核心要求包括Spark Core的RDD编程与依赖分析,Spark SQL的DataFrame/Dataset操作与Catalyst优化器原理,以及Spark Streaming的结构化流处理能力,对于高级岗位,候选人还需掌握Spark on Kubernetes的容器化部署、动态资源分配等进阶技能,以及PySpark在机器学习中的应用,如MLlib算法调优,性能优化是招聘重点,例如通过广播变量减少数据倾斜,使用Kryo序列化提升效率,或结合Tungsten引擎优化内存管理,实际场景中,企业常要求候选人具备从数据接入到实时分析的全链路经验,如基于Spark Streaming的实时风控系统搭建,或利用Structured Streaming处理用户行为日志。

从行业分布来看,互联网、金融、电商是Hadoop与Spark人才需求的主要领域,互联网企业如电商平台,依赖Spark进行实时推荐与用户画像分析;金融机构则通过Hadoop构建数据仓库,结合Spark进行实时交易监控;传统行业在数字化转型中,也大量招聘Hadoop/Spark工程师搭建数据中台,薪资水平因地域与经验差异显著,一线城市(如北京、上海、深圳)3-5年经验工程师年薪普遍在25万-45万,高级岗位可达50万以上,而新一线城市(如杭州、成都)薪资水平约为一线的80%-90%。

求职者需注意,Hadoop与Spark招聘并非孤立存在,企业常要求候选人具备“大数据生态全景能力”,熟悉数据采集(Flume、Kafka)、消息队列(Kafka、Pulsar)、数据仓库(Hive、Iceberg)等组件的协同工作,掌握数据湖架构(如Delta Lake、Iceberg)设计,编程语言能力(Scala/Java/Python)、Linux系统调优、JVM内存管理等基础技能也是硬性要求,对于应届生,实习经历与开源社区贡献(如GitHub代码提交、Spark社区邮件列表参与)能显著提升竞争力。

为帮助求职者更好地准备,以下整理了Hadoop与Spark招聘的核心技能对比:

| 技术方向 | 核心技能要求 | 常见面试场景 |

|---|---|---|

| Hadoop | HDFS架构、MapReduce编程、YARN调度、HBase/Hive优化 | 设计TB级数据ETL流程、解决NameNode内存溢出问题、编写MapReduce去重程序 |

| Spark | RDD/DataFrame操作、Structured Streaming、性能调优、MLlib应用 | 分析Spark作业执行缓慢原因、实现实时数据关联查询、设计机器学习特征工程流水线 |

相关问答FAQs:

Q1: 非计算机专业背景,如何转行从事Hadoop/Spark开发?

A1: 非专业背景者可通过系统学习弥补短板:首先掌握Java/Scala编程基础与Linux操作,再学习Hadoop生态(HDFS、MapReduce、Hive)入门教程,如《Hadoop权威指南》;接着重点突破Spark核心编程,通过官方文档与实战项目(如日志分析、用户行为统计)积累经验;最后参与开源社区或实习项目,提升实战能力,建议考取Cloudera或Databricks相关认证,增强简历竞争力,同时关注行业招聘需求,针对性补充数据仓库、实时计算等知识点。

Q2: Hadoop和Spark在面试中如何选择?哪个就业前景更好?

A2: 选择需结合职业规划:Hadoop更侧重批处理与数据存储,适合想深耕数据平台架构、离线数据分析的求职者,尤其在传统企业数据仓库建设中需求稳定;Spark则凭借实时计算、机器学习支持等优势,在互联网、人工智能领域更受欢迎,岗位增长更快,从就业前景看,Spark因内存计算与统一分析平台特性,逐渐成为主流,但Hadoop作为大数据基础设施,短期内仍不可替代,建议掌握Spark的同时,了解Hadoop生态,形成“Spark+Hadoop”复合技能,提升职业适配性。

文章来源网络,作者:运维,如若转载,请注明出处:https://shuyeidc.com/wp/365318.html<